Weisen wirklich zwei drittel aller Produkte ein zu gutes Rating auf?

Immer häufiger liest man in der Presse und verschiedensten Online News Portalen von “Fake Reviews“. Dies bezieht sich auf verschiedene Branchen und deren Internet-Plattformen, von Gastronomie über Travel bis hin zu Suchmaschinen. Namentlich geht es dabei meist um Booking.com, Tripadvisor, und Google. Und natürlich um Amazon.

Interessanterweise gibt es zum Thema „Fake Reviews“ bisher wenig Fachliteratur bzw. Studien. Jeder weiß, dass es „falsche“ bzw. gekaufte Rezensionen gibt, allerdings sind Ausmaß und Impact bisher nur wenig belegt. Vorreiter beim Aufdecken von „Fake Reviews“ sowie deren Bekämpfung sind meist Verbraucherschutzverbände oder ähnliche Akteure. In UK ist dies „Which?“, in Deutschland z.B. die Stiftung Warentest.

Wir von der gominga beschäftigen uns als Review Experten natürlich ebenfalls intensiv mit dem Thema „Fake Reviews“, um unseren Kunden mit Rat & Tat zur Seite zu stehen. Hier sei auch auf unser Kapitel „Produktbewertungen auf Amazon: Relevanz und Handlungsempfehlungen für Unternehmen“ im Buch „Amazon für Entscheider“ (vgl. Springer Verlag, April 2020) verwiesen.

Im Folgenden haben wir einen aktuellen Artikel der Stiftung Warentest zum Anlass genommen, das Thema „Fake Reviews“ und die Vorgehensweise bzw. Identifikation von „Fake Reviews“ genauer unter die Lupe zu nehmen. Dazu haben wir den Analyse-Tool-Anbieter ReviewMeta analog zur Auswertung von Stiftung Warentest genutzt und eine zusätzliche Vergleichsauswertung mit weiteren Rezensionsdaten durchgeführt und angewandt.

Neben unseren Erkenntnissen stellen wir noch weiterführende Links zum Thema, u.a. zu aktuellen Studien von „Which?“ aus UK sowie der Stiftung Warentest zur Verfügung.

„Fake Reviews“ – wieso überhaupt?

National wie international gibt es seit mehreren Jahren Studien, die den Einfluss von Rezensionen auf die Konsument*innen belegen. Dabei wird auch immer wieder ein Zusammenhang zwischen Bewertungen, Preis, und Abverkauf nachgewiesen. Daher ist es in gewisser Hinsicht nachzuvollziehen, dass es Versuche gibt das Geschäft durch die Manipulation von Bewertungen positiv zu beeinflussen.

„Fake Reviews“ sind meist dann wirkungsvoll, wenn das Produkt von einer weniger bekannten Marke stammt, da „Fake Reviews“ helfen können, die Online Reputation zu verbessern. Ebenso helfen sie bei Produkten mit nur wenigen technischen Attributen, weil Kaufinteressenten dabei mehr auf die Einschätzung anderer User angewiesen sind als bei Produkten, die sich durch ihre technischen Eigenschaften differenzieren. Wir haben beobachtet, dass eher niedrigpreisige Produkte der Manipulation unterliegen, da hier die Verbraucher*innen mehr auf den Sternewert und weniger auf den Rezensionstext schauen.

Angriffsfläche für Manipulation sind der Sterne-Wert, die Anzahl der Rezensionen sowie deren Verteilung zwischen den 1-5 Sternen, sowie einzelne „high quality fakes“ Rezensionen (Vgl. Which? 2020). Zwar haben die meisten Plattformen – so auch Amazon – mittlerweile sehr rigide Regeln für das Verfassen von Rezensionen und setzen diese auch immer besser mithilfe ihrer Algorithmen durch, aber dennoch kommt es nach wie vor zu gekauften oder anderweitig manipulierten Rezensionen. Das fängt bei „Family & Friends“ an und hört bei einer schon sehr professionellen Schattenindustrie mit Social Media Gruppen, Bezahldiensten, Bots, und Review Hijacking & Merging auf.

„Wie Verkäufer mit gekauftem Lob Kunden manipulieren“

(Stiftung Warentest)

Die Stiftung Warentest hat im Juni 2020 einen Bericht zu Fake Bewertungen auf Amazon veröffentlicht. In ihrer Recherche haben die Tester u.a. inkognito bei einer Agentur Bewertungen gekauft und anschließend mithilfe des Analyse-Tool-Anbieters ReviewMeta dann auf Echtheit analysiert. Weiterhin werden in dem Bericht Manipulationsmethoden erläutert.

Wir haben den Bericht zum Anlass genommen, uns die Methodik, Vorgehensweise und Ergebnisse genau anzuschauen und mit einem weiteren Datensatz zu vergleichen bzw. die Analyse zu replizieren.

Fragestellung und Ziel war für uns: kann man gekaufte Rezensionen wirklich gut identifizieren? Wie hoch ist der Anteil gekaufter Rezensionen, und gibt es einen Unterschied zwischen Markenprodukten und „no name“ Produkten?

Identifikation von Fake Bewertungen

Wie kann man gekaufte Bewertungen erkennen? Welche Kriterien gibt es dabei? Wie lässt sich ein solcher Prüfprozess automatisiert für große Datenmengen darstellen?

Grundsätzlich gibt es verschiedene Anhaltspunkte, die auf eine Manipulation hinweisen. Dabei werden einerseits die Verfasser*innen, andererseits die Rezension unter die Lupe genommen.

ReviewMeta ist eines der prominentesten Tools am Markt, um Rezensionen auf Amazon auf Echtheit zu prüfen. Die Firma sammelt zunächst Bewertungsdaten von den verschiedenen Amazon-Länder-Plattformen ein und unterzieht diese dann einer Prüfung auf Echtheit. So liegen zum heutigen Zeitpunkt für amazon.com beispielsweise 5,3 Millionen geprüfte Produkte vor, für amazon.de knapp 650.000 Produkte. Dies bedeutet natürlich, dass es sich um eine statische Prüfung handelt und nicht immer alle aktuellen Daten abgefragt werden können. Zudem beinhaltet der – zwar ohne Zweifel sehr große Datenschatz – längst nicht alle Produkte und deren Rezensionen. ReviewMeta wertet meist die Top 100 Produkte verschiedener Kategorien aus. Diese Topseller-Listen beinhalten dann – mal mehr, mal weniger – eine Mischung aus Produkten namhafter Markenhersteller und günstiger No-Name Produzenten. Das Tool ist gratis, sodass jeder entweder bei ReviewMeta direkt oder durch ein Browser Plugin einzelne Produkte abfragen und Rezensionen prüfen kann. Zuletzt sei noch erwähnt, dass ReviewMeta selbst nicht von „Fake Reviews“ spricht, sondern: „ReviewMeta analyzes Amazon product reviews and filters out reviews that our algorithm detects may be unnatural.“

”ReviewMeta selbst spricht nicht von „Fake Reviews“, sondern: „ReviewMeta analyzes Amazon product reviews and filters out reviews that our algorithm detects may be unnatural.“

Was hat gominga untersucht?

Wir haben mithilfe des Tools von ReviewMeta zwei unterschiedliche Review-Datensätze analysiert und verglichen. Die erste Testgruppe besteht aus 45 Produkten, bei denen wir von gekauften bzw. „incentivierten“ Bewertungen wissen. Die zweite Testgruppe beinhaltet 110 Produkte von Markenherstellern, bei denen es keine gekauften / „incentivierten“ Bewertungen gibt. Allesamt gut gepflegte Sortimente mit durchweg organisch generierten Bewertungen, und einem aktiven Customer Support, der auf negative Bewertungen reagiert und Fragen beantwortet.

Unsere Fragestellung war also:

- Erkennt ReviewMeta tatsächlich gekaufte Bewertungen?

- Wie viele Bewertungen markiert ReviewMeta als „unnatürlich“?

- Wie verändert sich der Sterne-Wert durch ReviewMeta’s Aussortieren von „unnatürlichen“ Bewertungen?

Außerdem war für uns interessant, ob man einen Unterschied zwischen günstigen, No-Name Produkten (oftmals Handyhüllen, Accessoires, Kabel, Trinkflaschen etc.) und den Produkten der Markenhersteller erkennt.

Wichtig bei der Analyse und den Ergebnissen ist die Berechnung des Sterne-Wertes. Sowohl ReviewMeta als auch wir selbst können diesen immer nur mit dem arithmetischen Mittel der Bewertungen berechnen. Amazon hingegen nutzt einen Algorithmus, in den verschiedene, nicht bekannte Faktoren einfließen. Zwischen dem bei Amazon dargestellten Sterne-Wert und dem rechnerischen Wert besteht daher meist eine erhebliche Diskrepanz.

Amazon erläutert die Berechnung des Sterne-Wertes wie folgt:

”Diese Modelle berücksichtigen verschiedene Faktoren, darunter beispielsweise wie aktuell die Bewertung ist oder ob es sich um einen verifizierten Kauf handelt. Sie verwenden mehrere Kriterien zur Bestimmung der Echtheit des Feedbacks. Das System lernt und verbessert sich im Laufe der Zeit weiter.

Wir berücksichtigen in der sternebasierten Gesamtbewertung von Produkten keine Kundenrezensionen, die nicht den Status "Verifizierter Kauf" haben, solange der Kunde nicht weitere Details in Form von Text, Bildern oder Videos hinzufügt.

Sowohl wir, als auch ReviewMeta, berücksichtigen in unseren Berechnungen ausschließlich jene Bewertungen mit Text. Obwohl verifizierte reine Sternewertungen ohne Text durchaus in den Gesamtdurchschnitt einfließen, sind diese derzeit nicht mit externen Mitteln erfassbar, weder für uns noch für ReviewMeta. Lediglich über einen Vergleich, wenn das Produkt bereits zuvor erfasst wurde, können diese näherungsweise ermittelt werden.

Prüfkriterien und Prozess von ReviewMeta

Der Prozess von ReviewMeta überprüft alle Bewertungen anhand von verschiedenen Kriterien, nach denen entweder die Bewertung oder der Verfasser als ‚unglaubwürdig‘ eingestuft werden – diese sind:

Verfasser:

- Brand Repeaters

- Brand Loyalists

- Brand Monogamists

- Never-Verified Reviewers

- One-Hit Wonders

- Overlapping Review History

- Reviewer Participation

- Single-Day Reviewers

- Take-Back Reviewers

Bewertung:

- Deleted Reviews

- Incentivized Reviews

- Phrase Repetition

- Unverified Purchases

- Word Count Comparision

Als Ergebnis wird von ReviewMeta ein Katalog erzeugt, der nach verschieden Kriterien (s.u.) entweder einen „FAIL“ meldet, wenn zu viele Auffälligkeiten registriert wurden, ein „WARN“ bei einer mittleren Zahl und „PASS“ wenn keine der angelegten Kriterien negativ erfüllt wurden. Wir haben uns im Folgenden nur die Fails angesehen.

ReviewMeta überprüft die Produkte nicht in regelmäßigen Abständen. In unseren Untersuchungen kam es vor, dass der letzte Scan des jeweiligen Produktes mehrere Wochen oder Monate zurücklag bzw. dass das Produkt noch nie erfasst wurde. Manchen Auswertungen liegen also nur ein bis zwei, vielleicht drei Scans zugrunde. Entsprechend vorsichtig sollten die Schlussfolgerungen betrachtet werden, da bei einigen Prüfkriterien (wie z.B. Deleted Reviews) die Aktualität der Daten sehr wichtig sind.

Ergebnisse der gominga Analyse

Im Folgenden zeigen wir die Ergebnisse unserer Analyse für die beiden Testgruppen detailliert auf und gehen dabei auf die Bereiche „Anpassung des Sterne-Werts“, „Anzahl verdächtiger Bewertungen“, sowie die Hauptkriterien der als „unnatürlich“ identifizierten Bewertungen ein.

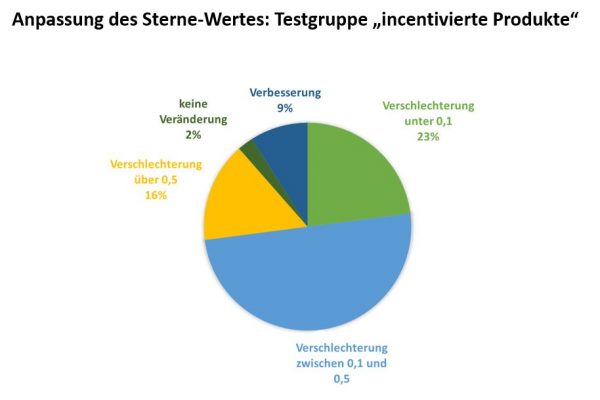

Anpassung des Sterne-Wertes

Was das Aussortieren der „unnatürlichen“ Bewertungen und damit die Neuberechnung des Sterne-Wertes angeht, ist das Verhältnis zwischen beiden ausgewerteten Gruppen weitgehend ähnlich. Die Differenz des „alten“, bei Amazon angezeigten Sterne-Wertes, und des „neuen“ Sterne-Wertes hat sich bei beiden Gruppen ähnlich verändert.

Den größten Anteil machen jeweils Veränderungen in der ersten Nachkommastelle aus. Zwischen fast 73% (Testgruppe mit „incentivierten“ Bewertungen) und 62% (Testgruppe der Markenprodukte) zeigen eine Veränderung kleiner als 0,5 und damit in der Regel unter der Rundungsgrenze für den graphisch dargestellten Stern auf Amazon. Davon liegen zwischen 23% und 19% sogar unter 0,1.

Diese Anpassung geht zum größten Teil auf die unterschiedliche Berechnung durch den bei Amazon dargestellten Sterne-Wert und des arithmetischen Mittels der Nachberechnung zurück. Denn bei den hier ausgewerteten Produkten wurden die wenigsten Bewertungen (im Vergleich zu den anderen Clustern) komplett durch die Regeln von ReviewMeta aussortiert, d.h. hier fand die geringste Anpassung statt.

Bei 16% für die Testgruppe mit „incentivierten“ Bewertungen und 21% bei den Produkten der Markenhersteller kann eine größere Veränderung des Sterne-Wertes von über 0,5 festgestellt werden. Dies hätte dann zur Folge, dass es auf Amazon bei der graphischen Darstellung des Sterne-Wertes zu einer Veränderung kommt. Beispielsweise werden dann 4 volle Sterne statt 4 ½ angezeigt.

Bei 9% der Produkte mit „incentivierten“ Bewertungen und bei 15% der Produkte der Markenhersteller kommt es durch die Anpassungen von ReviewMeta sogar zu Verbesserungen des Sterne-Wertes. Sprich, es werden negative Bewertungen als „unnatürlich“ identifiziert.

Bei jeweils 2% der Produkte kommt es zu gar keinen Veränderungen.

Anpassung der Anzahl der Reviews

Die Produkte der Testgruppe mit „incentivierten“ Bewertungen hatten vor der Analyse durch das ReviewMeta Tool im Schnitt 41 Bewertungen. Die Testgruppe der Markenprodukte 423. Die Gründe hierfür sind vielfältig. Man könnte behaupten, dass Markenprodukte von sich aus bei den Verbaucher*innen bekannter sind und daher auch öfter bewertet werden. Weiterhin werden die Produktpräsentationen von den Markenhersteller vermutlich besser gepflegt und das Thema Reviews sowie Q&A wird aktiv gemanagt. Dem hingegen weisen die Produkte der Testgruppe mit „incentivierten“ Bewertungen wesentlich weniger Reviews auf, was ja der ursprüngliche Grund ist überhaupt Bewertungen zu erkaufen.

Für das Aussortieren und Anpassen der quantitativen Menge der Rezensionen hat dies natürlich zur Folge, dass die Möglichkeit überhaupt eine große Anzahl an „unnatürlichen“ Bewertungen zu finden bei den beiden Testgruppen durchweg ungleich ist.

Bei der Testgruppe mit „incentivierten“ Bewertungen lagen bei 61% gar keine Veränderungen bei der Anzahl der Reviews vor, d.h. bei 61% gab es keinerlei Beanstandungen bzw. führten diese nicht zum Ausschluss. Bei den Markenprodukten betrifft dies nur 16%.

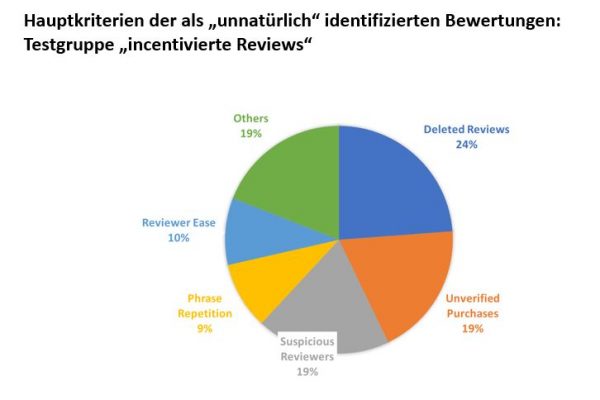

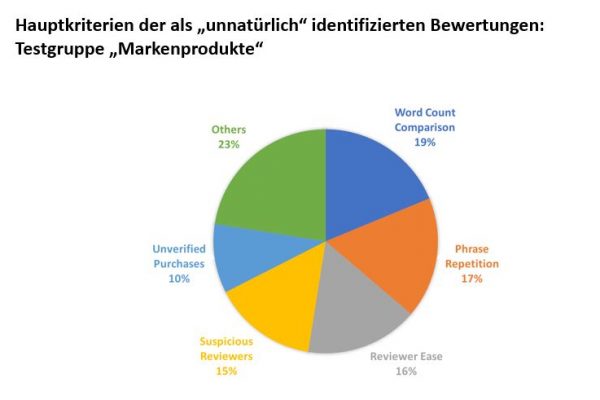

Hauptkriterien der als „unnatürlich“ identifizierten Bewertungen

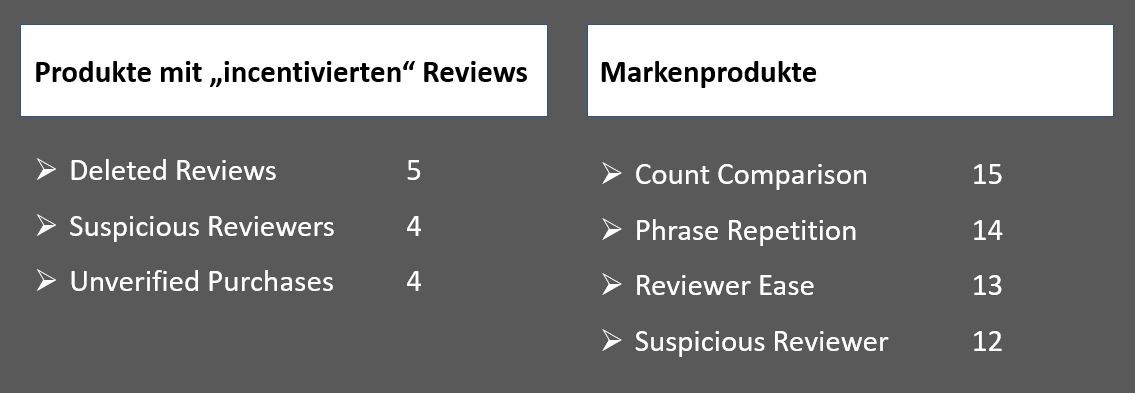

Vertiefend haben wir uns jeweils die auffälligsten Veränderungen hinsichtlich Anpassung der Anzahl der Reviews für beide Testgruppen angesehen. Das war im Portfolio der Markenprodukte bei 18 Produkten (mit über 50% Anpassung) und der Gruppe „mit incentivierten Bewertungen“ bei 6 Produkten (mit wenigstens 40% Anpassung) der Fall.

Uns interessierte, welche Bewertungen mit welcher Begründung als „unnatürlich“ eingestuft wurden. Die folgende Tabelle zeigt die Kriterien mit den meisten als „unnatürlich“ identifizierten Bewertungen der beiden Testgruppen:

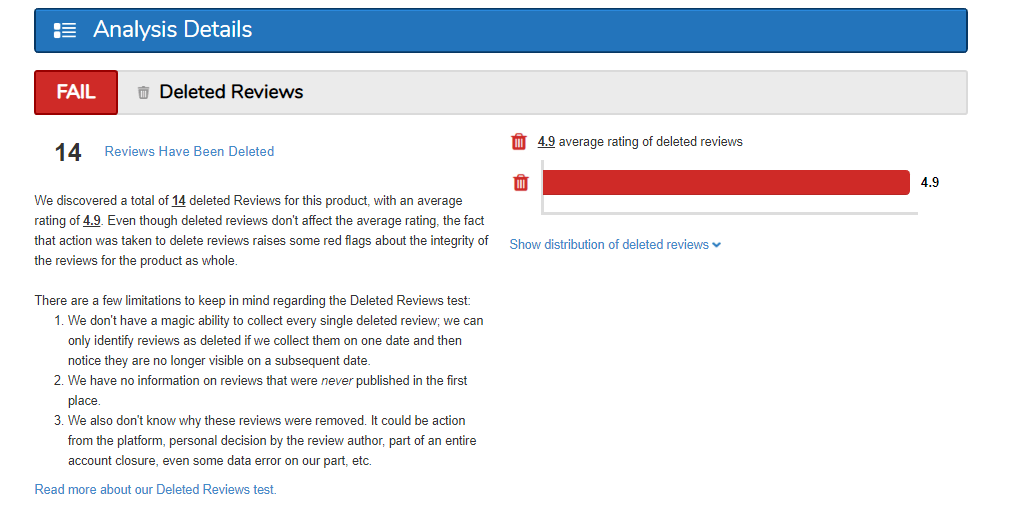

Deleted Reviews

ReviewMeta analysiert die Bewertungen des jeweiligen Produkts in unregelmäßigen Abständen. Stellt ReviewMeta fest, dass eine zuvor veröffentlichte Bewertung nicht mehr verfügbar ist, gilt diese als „Deleted Review“, also als gelöschte Bewertung. Weshalb die jeweilige Bewertung gelöscht wurde, weiß ReviewMeta indes nicht. Werden viele Bewertungen gelöscht, gilt dieses Verhalten für ReviewMeta als unseriös.

Es gibt jedoch zahlreiche Gründe für Amazon, eine Rezension zu löschen oder gar nicht erst zuzulassen:

”„ […] Hinweise auf Preisgestaltung, Produktverfügbarkeit oder alternative Bestellmöglichkeiten sollten weder in Kundenrezensionen noch unter Fragen und Antworten genannt werden.“ Und „Kundenrezensionen und Fragen und Antworten sollten sich auf den jeweiligen Artikel beziehen. Feedback zu Marketplace Verkäufern oder zu Versandproblemen können [an anderer Stelle] abgegeben werden.“

(Quelle: https://www.amazon.de/gp/help/customer/)

Wenn also beispielsweise in einer Bewertung der Versand kritisiert wird oder aber Marketplace Händler, dann entfernt Amazon eine solche Bewertung.

Ist der Hersteller bzw. dessen Customer Support auf Amazon aktiv und forciert die Löschung derart unpassender Bewertungen, bringt das dem Produkt nach den Kriterien von ReviewMeta Minuspunkte.

Amazon löscht auch Bewertungen, wenn eindeutig auf Produkttests verwiesen wird und es sich nicht um das Amazon-eigene Vine Programm handelt. Allerdings führen auch persönliche Daten oder Verweise auf andere Shops zur Löschung, allesamt Kriterien, die keine Aussage über die Echtheit der Bewertung zulassen. Die Anzahl der Bewertungen, die durch den Benutzer selbst gelöscht werden, ist nach unserer Erfahrung dagegen verschwindend gering.

Und noch einmal der Hinweis der Datenerhebung von ReviewMeta: Die Berechnung gelöschter Bewertungen bei ReviewMeta beruht allein auf einem ‚Vorher-Nachher‘. Sprich, eine Aussage zu Deleted Reviews kann nur gezogen werden, wenn das gleiche Produkt zuvor schon einmal erfasst wurde und eine Bewertung mit einem bestimmten TimeStamp beim nächsten Scan fehlt – wie ReviewMeta selbst erklärt:

”„We don't have a magic ability to collect every single deleted review; we can only identify reviews as deleted if we collect them on one date and then notice they are no longer visible on a subsequent date.“

Quelle: ReviewMeta

Suspicious Reviewers

Hierbei unterscheidet ReviewMeta vier verschiedene Fälle: „One-Hit Wonders“, „Single-Day Reviewers“, „Never-Verified Reviewers“ sowie „Take-Back Reviewers“. Dies ist beispielsweise eine Person, bei der es bei mindestens einer der abgegebenen Bewertungen zu einer Löschung gekommen ist.

”“[An amount of] reviewers have had at least one of their past reviews for another product deleted. This is an excessively large percentage of Take-Back Reviewers which may indicate unnatural reviews.”

Quelle: ReviewMeta

Unverified Purchases

ReviewMeta klassifiziert Bewertungen ohne einen vorherigen Kauf des Produkts auf Amazon als „unnatürlich“.

Bewertungen ohne einen vorherigen, verifizierten Kauf werden durch Amazon eingeschränkt. Auch wenn die häufig zitierte Amazon Regel, dass Kunden „[…] bis zu 5 Rezensionen pro Woche verfassen können, die nicht mit dem Zusatz „Verifizierter Kauf“ versehen sind“ aktuell aus den Richtlinien verschwunden ist, so bleibt die Möglichkeit Bewertungen abzugeben, die nicht einem Kauf zugeordnet werden können, eingeschränkt und es kann nur eine „unverifizierte“ Bewertung abgegeben werden, wenn häufiger auch verifiziert bewertet wird. Wenn dennoch ein Produkt eine hohe Anzahl an unverifizierten Bewertungen aufweist, behält es sich Amazon vor, dieses Produkt generell für die Bewertungsaktivität zu sperren. Abgesehen davon bieten verschieden Portale auch Incentiviert Verifizierte Bewertungen an. Ob das Kriterium Unverified Purchases nun ein eindeutiger Identifier für eine „gekaufte“ Bewertung ist, kann aus unserer Sicht nicht eindeutig begründet werden.

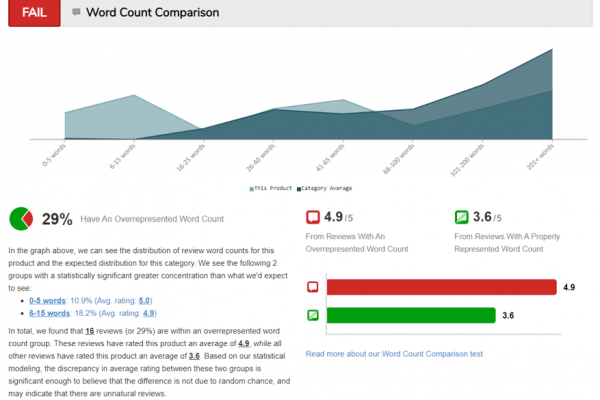

Word Count Comparison

Dieses Kriterium zeigt eine Häufung von Bewertungen mit einer bestimmten Länge, also Anzahl an Wörtern. ReviewMeta misst dabei die Länge eines Rezensionstextes und vergleicht diese dann mit anderen Bewertungen vergleichbarer Produkte.

Ein ‚FAIL‘ bei diesem Kriterium bedeutet, dass eine große Menge aller Bewertungen zu diesem Produkt eine bestimmte Anzahl an Worten hat, z.b. zwischen 6 und 15.

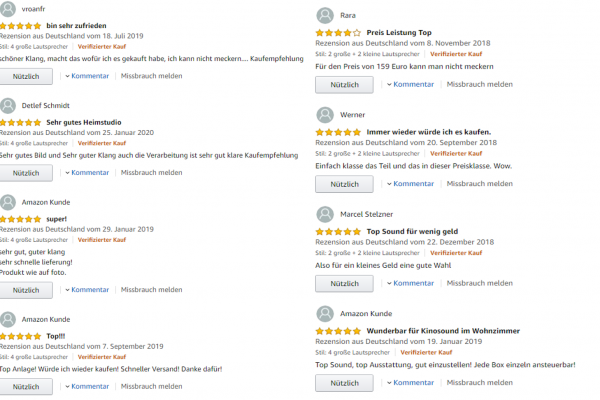

Die folgenden Graphiken illustrieren das Kriterium „Word Count Comparison“ und zeigen Bewertungen mit 6 bis 15 Worten. Die Beispiele der Amazon Seite sind organisch generierte Bewertungen aus verifizierten Käufen. Es bleibt fraglich, ob eine solche Bewertung aufgrund der Textlänge als „unnatürlich“ eingestuft werden kann.

Phrase Repetition

ReviewMeta sucht hier nach einer Häufung bestimmter Worte und Ausdrücke. Unsere Auswertung zeigt, dass selten Hinweise auf Produkttests auftauchen, dagegen besonders oft Begriffe wie „Qualität“ und „Preis“ genannt werden, oder „bin zufrieden“. Das entspricht unserer Beobachtung nach, dem durchschnittlichen Bewertungsvokabular und ist an sich noch keine Auffälligkeit.

Im Datensatz der Testgruppe der „incentivierten“ Produkte wurde nur in genau einer Bewertung der Ausdruck „wurde mir kostenfrei zu Testzwecken zur Verfügung gestellt“ gefunden. Die übrigen Treffer bezogen sich auf „Qualität“, „Preis“ und „Design“.

Reviewer Ease

Dies ist die Beobachtung, dass ein Bewerter einen besonders guten Gesamtdurchschnitt seiner Bewertungen aufweist, d.h. die Bewertungen meistens 4 oder 5 Sterne haben.

Brand Repeats & Overlapping Review History

Die Kriterien Brand Repeats (mit nur 1% entspricht 1 Treffer) oder Overlapping Review History (mit 6% entspricht 5 Treffer) werden nur verhältnismäßig selten gefunden. Hinter den Begriffen verbergen sich zum Einen Bewerter, die Produkte von ein und derselben Marke häufiger bewerten und zum Anderen, verschiedene Bewerter, die die identischen Produkte oft im gleichen Zeitraum bewerten. Dies lässt auf einen Bewerterpool einer Produkttestagentur schliessen. Genau diese relativ eindeutigen Identifier können jedoch nur sehr selten registriert werden.

gominga’s Fazit – Es bleibt schwierig

„Fake Reviews“ werden uns weiterhin beschäftigen. Verbraucherschutzbehörden sind dabei wichtige Instanzen, um die negativen Auswirkungen transparent zu machen und Druck auf die Plattformbetreiber wie Amazon auszuüben.

Unsere Analyse zeigt dabei, wie schwierig es ist „Fake Reviews“ zu identifizieren. Selbst mithilfe technischer Tools wie ReviewMeta ist es schwierig, zwischen authentischen und „unnatürlichen“ Bewertungen zu unterscheiden. Die Kriterien zur Identifikation von „Fake Reviews“ sind oftmals nicht eindeutig, und so können eben auch gekaufte Bewertungen nicht immer mit absoluter Sicherheit gefunden und aussortiert werden.

Unsere Analyse illustriert auch, welche Unterschiede es zwischen verschiedenen Produktgruppen und Sortimentsbereichen geben kann.

Aufgrund unserer Analyse konnten wir nicht eindeutig feststellen, dass die meisten Reviews ‚Fake‘ sind, und die überwiegende Zahl der Produkte zu gut bewertet ist. Wir konnten nur bei maximal einem Viertel der analysierten Produkte einen besseren Bewertungsdurchschnitt feststellen, der sich nicht durch die Rechenweise von Amazon relativieren ließ. In der Mehrzahl der Fälle bewegt sich der Grad der Anpassungen unterhalb der Rundungsgrenze bei Amazon – viel größer ist die Abweichung durch die Amazon-eigenen Algorithmen für die Berechnung des Sterne-Wertes.

Optimieren Sie Ihr Review Management mit gominga

Schützen Sie Ihr Unternehmen vor den negativen Auswirkungen gefälschter Bewertungen und optimieren Sie Ihre Online-Präsenz mit dem gominga Review Manager. Oder fordern Sie hier eine kostenlose Demo für unsere maßgeschneiderte Lösung an, um authentische Kundenbewertungen zu fördern und Ihr Vertrauen bei den Verbrauchern zu stärken.

Weiterführende Quellen

- Stiftung Warentest: Fake-Bewertungen Wie Verkäufer mit gekauftem Lob Kunden manipulieren (23.06.2020)

- Which?: Exposed: the tricks sellers use to post fake reviews on Amazon (05.06.2019)

- Which?: The real impact of fake reviews (29.05.2020)

- ReviewMeta: https://reviewmeta.com/

- Stummeyer/Köber: Amazon für Entscheider. Kapitel 8 „“Produktbewertungen auf Amazon: Relevanz und Handlungsfelder für Unternehmen“